緊接雲運算和物聯網(IoT),人工智能和(Artificial Intelligence,AI)和機器學習(Machine Learning,ML),可謂企業數碼轉型路上最炙手可熱的課題。

業界爭相追捧AI和ML,猶如那是穩佔先機、讓業務更上一層樓的不二法門。不過問題來了:據Google雲運算人工智能與機器學習首席科學家李飛飛指出,全球開發者約為2100萬人,惟數據科學家卻僅100萬人左右;當中具備人工智能開發技術的人才相當有限,故此預期能透過部署AI和ML獲利的企業僅佔少數。

致力降低AI入場門檻

Google雲運算人工智能與機器學習研發部負責人李佳則表示,她和李飛飛打從加入Google團隊開始,便以推廣AI為使命,旨在降低AI的入場門檻,並盡可能讓開發者、研究人員和企業能廣泛地運用AI。

「Google Cloud AI團隊於2017年,推出了Google Cloud Machine Learning Engine(雲端機器學習引擎),幫助具備機器學習專業知識的開發者,輕鬆建構出機器學習的模型,以處理各種類型和規模的數據資料。我們展示了包含:Vision、Speech、NLP、Translation,和DialogFlow等新世代機器學習API服務,透過建構於預先訓練好的模型,提升商業應用程式的規模和速度。」李佳續透露,目前全球超過1萬家企業採用了Google Cloud AI服務,包括Box、Rolls Royce Marine和Ocado等企業。

李佳相信,AI和ML所能帶來的效益和機遇仍有待開發,例如在醫療界別,智能醫院在病歷分析和研究方面等。此外,Google Cloud亦與多個垂直行業緊密合作,包括零售業、媒體與娛樂、金融、製造業、教育、農業,透過可執行特定工作的多款API,為這些行業提供眾多預先訓練好的機器學習模型。然而,目前AI多見於擁有充足人才和預算的大型企業,有能力建立高階機器學習模型的機構非常有限。即使企業能聘請AI或ML工程師,仍須投注大量時間並操作複雜的程序,以開發出客製化的機器學習模型。

輕鬆建立客製化圖像辨識機器學習模型

Google Cloud Machine Learning Engine可支援GPU訓練模型,但此服務是透過較大量的資料,訓練出普遍(General)的預測模型,難以逐一滿足不同企業的個別業務需求。有見愈來愈多企業傾向自訂設計和應用的機器學習模型,Google Cloud團隊遂朝著讓用戶可自動挑選合適模型,搭配參數調整技術自動調整參數,只須輸入原始數據即能建立出符合自家需求的預測模型的方向邁進。而上周正式推出的Cloud AutoML Vision,正是實現降低AI入場門檻的策略性方案。

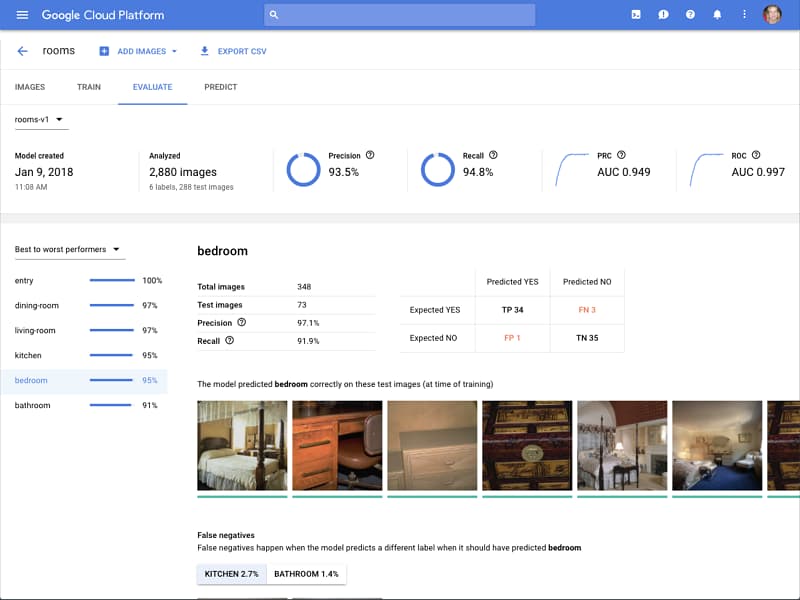

Cloud AutoML旨在協助機器學習專業能力有限的企業,開始運用learning2learn 和遷移學習等,由Google提供的先進技術,自行建立優質的客製化模型。而Cloud AutoML Vision能更快速、更輕鬆地建立客製化圖像辨識機器學習模型,讓企業能輕鬆地透過拖曳介面上傳影像、訓練和管理模型,然後直接在 Google Cloud上,有效地利用這些經過訓練的模型。相較於採用一般機器學習API,運用Cloud AutoML Vision來分類公開數據集,如ImageNet和CIFAR的初期成果更精準,也更少錯誤。

神經架構搜尋技術

李佳相信,Cloud AutoML除能提高AI專業人員的生產力、開展新的研究領域之外,還可幫助技術較不純熟的工程師,構建出強大AI系統。以迪士尼為例,產品搜尋毋須以標籤文字過濾搜尋結果,而是能透過搜尋某個角色相關產品,甚至其衣物如玻璃鞋,搜尋引擎就會靠影像辨識,來顯示含有這些卡通人物的產品。

Cloud AutoML Vision採用Google的影像辨識技術,包括遷移學習和神經架構搜尋技術,意味即使企業具備的機器學習專業知識有限,也能建立精確的模型。解決了機器學習的技術門檻後,只要具備開發能力,就算不懂機器學習知識,也能透過AutoML構建出一套企業級的ML應用或AI應用。李佳並透露,AutoML服務將先推出圖像自動標示的服務Vision,未來將陸續推出語音、翻譯和自然語言處理等服務。