[新科技速遞]

Facebook母公司Meta屬下Meta AI研究人員,宣佈以人工智能開發高質素機械翻譯,以NLLB-200命名的單一AI 模型,能翻譯出200種不同語言,支援多語言翻譯挑戰,包括了訓練低資源語言,也就是只有少數樣本供訓練AI模型的非主流語系。

故此,主流AI翻譯工具,仍不支援,或無法完全支援非主流語言(例如坎巴文和寮國文),常用翻譯工具只支援少於25種非洲語言,多數質素不佳。

NLLB-200則可支援55種非洲語言,提供高質素翻譯。Meta AI指,NLLB-200雙語替換評測分數(BLEU score)在 FLORES-101基準所有10,000個方向,較現時最先進翻譯工具分數平均提升44%。部分非洲和印度語言中,幅度提升七成。

Transformer再顯神通

Meta AI為評估和改善NLLB-200,建立FLORES-200的多對多評估數據庫,研究人員可以評估40,000個不同語言方向的效能。Meta AI將開放上述數據集原始碼,以便迅速測試及改善翻譯模型。FLORES-200可用於評估各種翻譯應用,服務只有少數語言資源可供參考的地區。

Meta AI透過自行開發「LASER」工具支援機器學習的翻譯,訓練的神經網絡先以一種語言執行特定任務,然後再相對容易令神經網絡適應其他語言的翻譯,新一代LASER又改用Google開源Transformer神經網絡框架,改以遮罩語言建模(Masked Language Modeling)進行自我監督式訓練Transformer模型。

Transformer是近年 NLP 領域關注度最高神經網絡框架,2017 年由Google 研究人員發表題為「Attention Is All You Need」論文後,破天荒提出基於注意力機制(Attention mechanism)框架後,Transformer幾乎席卷了「自然語言處理」(Natural Language Processing,NLP),也開始應用在視覺運算。

所有AI模型訓練的機械翻譯都需要大量數據。對文字翻譯系統,通常包括數百萬個多種語言之間仔細配對的句子,但英文與低資源語言之間,很難找到大量平行結構句子,經常要透過網絡挖掘的數據來克服,結果每種語言文字來源不同,質素通常不佳,數據充斥著錯誤或不一致的拼法,遺漏重音符號和其他變音符號。

混合專家克服困難

Meta AI開放多語言的超精準翻譯模型原始碼,希望其他研究人員擴大訓練基礎,以便NLLB-200更精凖翻譯至更多語言。Meta AI甚至向非牟利組織提供最多二十萬美元補助金,以推廣NLLB-200實際應用。

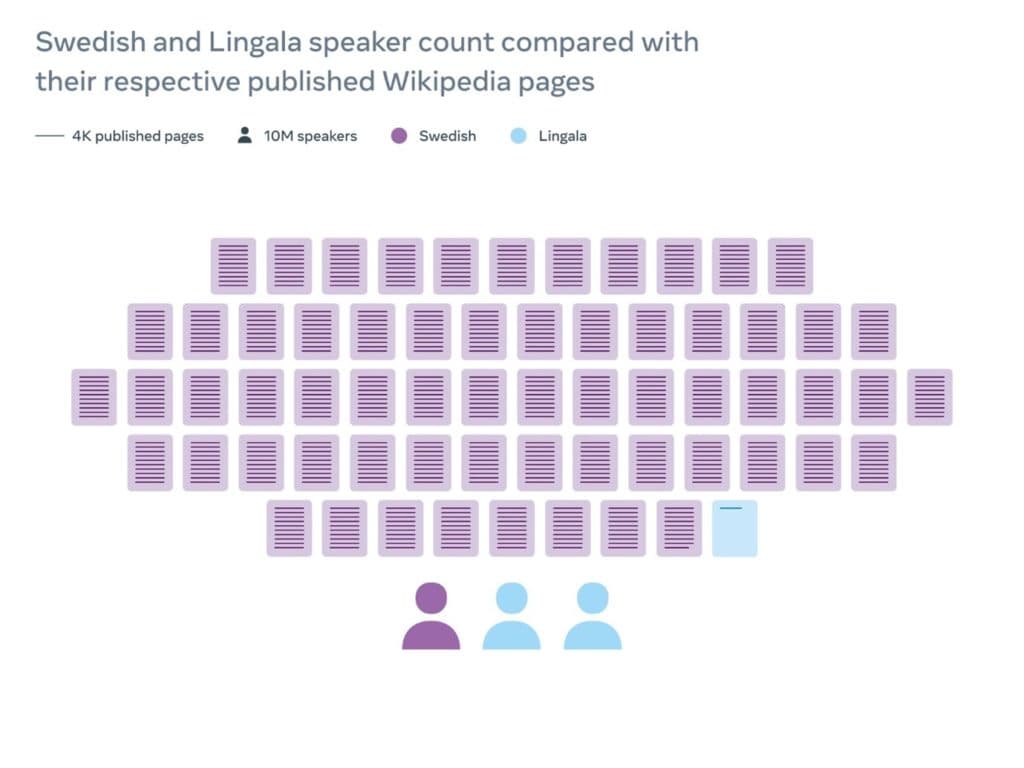

NLLB亦將支援Facebook動態消息、Instagram 和其他平台每日超過250億則翻譯內容,支援更多語言精準翻譯,NLLB有助Facebook辨別有害內容和錯誤資訊、維護廉正選舉,遏制網絡性剝削和人口販賣等。社交網絡充斥大量失實和偏見內容,更成為激端主義溫床,而多語言翻譯可以有助監察,維基百科的編輯人員所用翻譯系統,亦採用源自 NLLB研究的建模技術和成果。

不過,Transformer框架建立的低資源語言翻譯,Microsoft和Google都有新部署,尤其以Google更可能達到上千語言的精確翻譯。

Microsoft的NLP也是全球最先進AI研究,Azure Cognitive Service可支援103種語言,Microsoft公佈NLP加入Transformer模型,採用Z-Code模型顯著提高翻譯質素,透過混合專家(MoE)架構,模型同時學習多種語言之間翻譯,即使低資源語言缺乏大量訓練數據,亦可提高翻譯來源語言的質素。

MoE亦是Google研究人員2017年提出,NLP訓練藉此提高性能及針對低資源語言。雖然NLLB-200模型亦利用MoE在無損效能情況下,以新結構擴大模型規模,低資源語言自動轉送至共用數據容量,只要與設計良好正規系統結合,便能避免語言過多的過度配對問題,改善翻譯成果。但NLLB-200在翻譯Oromo、冰島、希臘和亞美尼亞語,效果仍強差人意,顯示MoE也須更多數據集。

相對之下,5月份Google在Arxiv公佈「為下一千種語言構建機器翻譯系統」論文,更令人期待,畢竟Transformer和MoE兩個技術突破,都來自Google研究人員,Google又坐擁有全球最多數據,為上千數低資源語言建立了數據集,毋須像Meta AI般四處張羅。

NLLB-200模型從 100 種語言擴展至 200 種語言,已存在不少挑戰;全球有超過7000種語言,即使NLLB-200可支援200種語言,人類離回到「巴別塔」以前的世界,仍然相當遙遠。