新科技速遞

量子運算(Quantum computing)是新一代的運算技術,有機會解決人類最棘手的難題。不過量子電腦的糾錯(Error Correction)困難,一直困擾科學家。全球科技企業都為開發可商用的量子電腦而大灑金錢。

量子計算機以量子比特(Qubit)的疊加和糾纏狀態計算,原理有如分子在自然界的狀態,可模仿分子的各種行為和相互作用,以測試和發明新材料,可用於開發電池、室溫超導,甚至解決人類的糧食危機。

2019年,Google宣稱率先達到「量子優越性」(Quantum supremacy),其量子處理器Sycamore解決了傳統電腦無法解決的難題;今年,中國科大潘建偉教授和陸朝陽的團隊,亦公佈了76個光子的量子運算「九章」,也達到量子優越性,不過上述兩者,皆非於解決實際的難題。

量子運算暫時缺乏實用性,皆因是靠量測物理性的量子比特(Physical Qubit),依賴量子力學效應(即疊加和糾纏)相當脆弱,容易受干擾而引致錯誤。

傳統計算機的糾錯機制,一般以計算CRC碼檢測。量子運算每個量子比特,都處於混合的狀態,任何直接的檢測,都可能破壞數據。

大部分現實的運算問題,錯誤率要介乎10 ^-15以下的精確度,量子計算錯誤率約為10^ -3。目前,量子計算處理尚處於物理原型,只針對獨特設計的問題,也就其能處理的問題而已;離開實際商用,還很遙遠。

拓樸量子運算受挫

量子計算要解決糾錯,一直是最大挑戰;其中一種方法是透過拓撲理論,其中又以馬約拉納費米子(Majorana fermion)研究,最廣為人熟悉。2018年,Microsoft荷蘭台夫特理工大學的研究員,透過半導體材料和超導製作的奈米線材,宣稱發現Majorana fermion存在的證據。

馬約拉納費米子作為半電子態的准粒子,受到集體拓撲行為的保護,就好像一群人一起跳舞,互相扶持,大大降低所受干擾。問題在過去三年來,無人能證實上述的實驗;今年初Microsoft指基於「科學嚴謹性不足」,終於從《Nature》期刊上撤稿,但有關馬約拉納費米子研究不斷,拓樸量子運算是否可行,仍是未知之數。

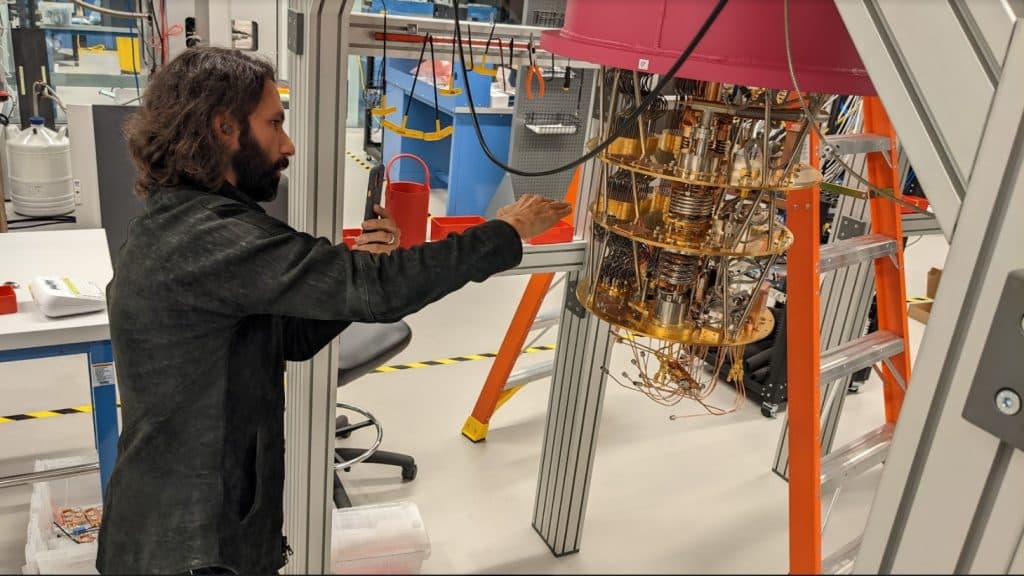

Google在量子計算上領先,今年加州Santa Barbara建立了Quantum AI園區,聲稱10年內商用量子運算。Google Quantum AI首席科學家Erik Lucero向傳媒展示Quantum AI各項設施,包括了量子運算數據中心、量子設備硬件研究中心,量度量子比特的特殊房、處理器裝配的中心,還有是首部以邏輯比特量子糾錯的量子電腦。

Google另闢蹊徑

Quantum AI採用是超導量子電腦,在超導環境下運算,再量度處理器的量子比特,超導量子計算的設計複雜,需於超低溫下運行,建造維護困難昂貴,必須先以氦氣冷卻,超導量子電腦狀如吊燈,處理器則位於底部,也是最冷凍部分,其餘都是電子元件。

Lucero表示,一般室溫約300 Kelvin(約是攝氏26度),量子處理器在低溫運作,旁邊是液態氦罐,溫度約為4 Kelvin(攝氏-269.15度),再經壓縮和氣化熱交換降溫的層層低溫恆溫器,到達處理器時,只有10 millikelvin(攝氏-273.14度),距離絕對零度的0 Kelvin(攝氏-273.15度)只高出僅0.01度!

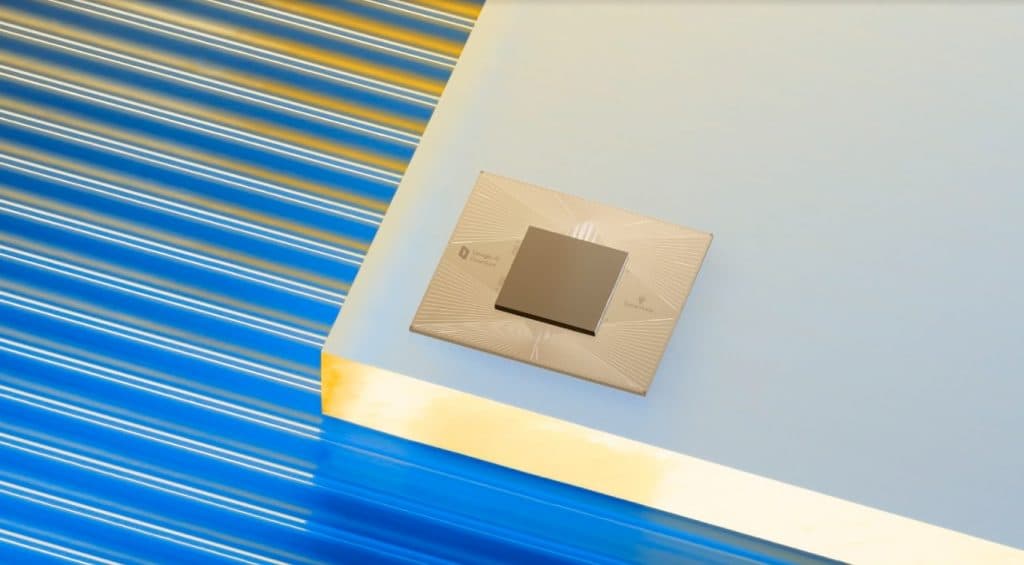

低溫的原因是Sycamore處理器以鋁金屬製造,低溫下變成了超導狀態,溫度愈低愈能收集到精確的量子比特訊號,大大減低了雜訊。

超低溫就為了產生超導,儘量消除所有干擾,但其實Google的量子電腦,仍受大量的雜訊干擾,加上超導量子比特的「退相干」(Decoherence)時間很短,量子操作要在退相干之前完成,記憶又消失很快,更要為物理量子比特作出糾錯。

Lucero介紹了Google正在建造以邏輯量子比特(Logical Qubit)糾錯,最終極就是開發出具糾錯功能的量子電腦,以達到商用目標。

邏輯比特譜出樂章

理論上,檢測量子運算機錯誤,可將多個物理上量子比特,變成了邏輯量子比特,不破壞邏輯量子比特的儲存下,實時發現糾正錯誤。

較早前Google在《Nature》就有關研究刊登論文, Sycamore處理器上在嵌入的超導量子比特的二維網格(two-dimensional grid of superconducting qubits)加入一維鏈重複碼(one-dimensional repetition codes),從邏輯比特量子成功驗證了糾錯超導量子比特的可能性。邏輯比特量子的比特數量從5個增加到21個,抑制邏輯錯誤的效果,增加了100倍。

Google是透過電子控制設備建立邏輯量子比特,好比將物理比特量子的訊號,把波浪變成了樂譜,加入邏輯量子比特後,再通過統計方法糾錯。量子電腦處於極低溫下,內部沒有任何地磁場(Earth magnetic field),可通過磁性合金(Mumetal),精確搜集數據到電子設備變成邏輯量子比特。

重複碼基於對邏輯錯誤的抑制,可實現倍數增長。Google發現每增加一個物理量子比特,邏輯量子比特的錯誤率,可大幅下降。雖然不能直接檢測每一個額外的量子比特,但邏輯量子比特可一起測量,仍推斷出量子運算是否發生了錯誤。

Google預計可以1000個物理量子比特,製造出一個邏輯量子比特,再一同作運算。但條件是採集數據的保真度(Fidelity)必須足夠高,加上Sycamore處理器,只有54個物理量子比特,路途仍然遙遠。

Google Quantum AI首席科學家Erik Lucero表示「目前量子計算仍然處於模擬運算(Analog computing)狀態,還未進入數碼運算 (Digital computing),邏輯量子比特糾錯一旦取得成功,就可研發出具糾錯功能的量子電腦,就可算是真正進入數碼時代,並且進入商用階段。」