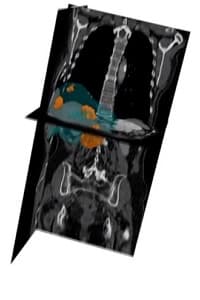

SAS的Viya平台可將從病人的CT影像,加上放射治療醫生的勾劃,合成計算出3D幾何掃描影像,清楚顯示出病變立體形狀,並可360度檢視影像和計算大小。

隨著機器學習和深度學習進步,人工智能(AI)應用幾乎無處不在,大量應用在金融、醫學,甚至是日常決策;不少人會問,AI是否會有偏見,如何可相信AI決定?

機器學習或深度學習,都涉及數據準備和構建模型,從提取數據特徵,自動化作出決定或建議。用戶只需數下點擊,便可自動獲取見解。數據科學家則將數據分析週期中不同步驟;包括數據準備、工程、模型構建及部署等自動化,更快產生不同AI模型。

問題是模型是否可信?如果證明模型決定正確,不帶偏見?如果AI模型要作出關鍵決定,上述問題就更加舉足輕重。

SAS很早開始應用數據科學在醫學用途。SAS與荷蘭Utrecht大學UMC (University Medical Center, Utrecht)新生嬰兒科,合作以大數據照顧早產嬰兒。每年,全球有約一成嬰兒屬於早產。雖然說,初生嬰兒周產期死亡率(PNM, Perinatal mortality)已大為降低,嬰兒早產極易受感染,導致新生兒敗血病(Sepsis)等問題。抗生素又會對嬰兒有副作用,兒科醫生進退兩難。

UMC新生嬰兒科蒐集了了超過10年臨床數據,累積電子病歷和醫療數據,展開了醫學應用數據科學(Applied Data Science in Medicine,ADAM)計畫;首個項目就是利用SAS機器分析和AI技術,以大數據模型預測早產嬰兒受感染的機率,SAS開發的算法,避免沒受感染早產嬰兒,不必要使用了抗生素。

以往,據估計有超過六成早產嬰兒,均不必要地使用抗生素,導致長大後多種問題。SAS的模型預測嬰兒受感染可靠程度,高達九成,較小兒科醫生還凖確。醫生觀察病徵和病人檢查斷症,一般凖確率只有四成左右。

最近,SAS又再與荷蘭醫學機構合作,應用視覺運算在癌症上,解決更棘手難題。

助癌症手術決策

SAS與阿姆斯特丹大學的癌病中心合作,該中心癌症外科主管Geert Kazemier教授說,直腸癌肝轉移( Colorectal Liver Metastases)病人患上直腸癌後,癌細胞再轉移至肝臟,成為主要致死原因;而手術切除又為最有效治療手段,甚至是病人唯一希望。

「直腸癌是西方第三大常見的癌病,超過一半患者的腫瘤,從大腸蔓延至肝臟。雖然局部切除(Resection)有問題組織,為最有效治療手段,部分腫瘤體積太大,又或過於密集,就須先進行化療,先縮小腫瘤再施手術切除。」Kazemier表示,化療不能根治腫瘤,卻往往是手術先決條件。

評估腫瘤那個階段切除,必須放射治療科醫生判斷。按國際標準固體腫瘤反應評估標準(RECIST)評估化療效果,從CT影像選擇兩個病變(Lesion)範圍,化療後如果腫瘤縮小了三成,代表有療效可進行切除;腫瘤繼續長大代表沒療效;維持不變或縮少於三成,代表腫瘤穩定,仍未適合切除。

但是,放射治療科醫生以人手量度腫瘤體積,也影響抉擇時診斷的客觀程度。首先選擇那兩個病變的範圍,或者選擇CT影像橫切面,也可能令結果有偏差。

Kazemier說,RECIST標凖之所以只取其中兩個病變範圍,主要放射治療科醫生缺乏足夠時間,檢視所有細節,但以AI檢視影像,卻沒以上限制。

SAS與阿姆斯特丹大學合作,以AI視學運算檢測病人的療程反應,並作凖確和客觀的自動化檢測。SAS視覺運算專家Fijoy Vadakkumpadan利用從阿姆斯特丹大學3D幾何圖像、根據多位病人RECIST數據,以及放射治療醫生,從CT影像勾劃出病變輪廓,供人工智能建立深度學習模型。

SAS的Viya平台可將從病人的CT影像,先合成為3D幾何掃描影像,清楚顯示出病變的立體形狀,並可360度檢視影像。

Kazemier說,目前全球的放射治療科,都只以平面掃描作RECIST的檢視,卻沒有考慮腫瘤的實際容積。SAS的Viya平台390度影像,可說是一大突破;3D影像比平面更凖確顯示腫瘤大小。以往療程後CT平面影像,表面看來少於3成縮減,以3D影像計算後,卻可能出現了不同結果。

「上述量度對性命尤關,以Viya平台構成的立體影像來判斷,病人可能更可把握手術的時機,結果救回一命。」

SAS利用深度學習,也可訓練出自行找出癌腫瘤病變,所獲的結果可跟放射治療科醫生判斷,幾乎完全一致。

AI也有偏見

不過,AI只作為一種預測,跟人類一樣,有犯錯的可能。

AI是經過機器學習或深度學習建立的模型,模仿人類的決策過程。SAS技術總監Oliver Schabenberger說,數據只是世界剪影,AI須利用足夠數據,以算法訓練,即使算法如何精確,AI不會取代人類,並須向用戶解釋,AI模型如何運作,必須具備可解讀性(Interpretability),即模型如何根據數據作出反應,以消除模型偏見和誤差。

Schabenberger說,AI模型甚至要具「可解釋性」(Explainability),更進一步以人類能理解的語言,向用戶說明AI模型如何運作,所作決定是否合規。以上述醫學影像平台,Viya平台除了會標示AI模型判斷的信心程度,還會以語言文字,向放射治療科醫生解釋,何以某些影像,會被診斷為病變。

SAS結合了另一項AI的自然語言處理技術,再加上以統計運算出的Shapley數值,找出各個因素在AI模型所作的貢獻,再變成可理解的文字,可說是統計學和AI的結合。

Schabenberger說,以往AI模型,可能只決定簡單的事情,很少人會關心解讀性和解釋性。但當AI的建議愈來愈重要;包括醫學上影響斷症,決定學生應否入學,又或是否向客戶批出貸款,就不能再掉以輕心,須確保不帶偏見,沒有受任何干擾,甚至符合法規遵從的原則。

所以SAS開發的AI模型,除了機器可以明白,還要讓人讀得懂。