[新科技速遞]

生成式AI發展如火如荼,大模型百花齊放。大模型要更加實用,得解決幾項難題。首先須理解人類意圖,有更準確推理能力;接收更多的輸入,也就是所謂「上下文長度」(Context Windows)。

大模型進步神速,最近MoE(混合專家模型)如雨後春筍,分開訓練的專家模型,可提供更精準答案,速度更快,即將面世GPT-5,其中包括16個專家模型。

近期研究更指出,大模型只要「問得其所」,可進一步發揮潛力。紅杉資本舉行AI Ascent會議上,史丹福大學吳恩達教授發表AI智能代理(Agent)的應用結果,引發起廣大迴響。

智能代理事半功倍

一般人利用大模型,都會以Zero Shot方式發問,也就是一問一答,天馬行空輸入,實際上是由大模型自行編碼,回答往往是強差人意。

吳恩達指,原來改變溝通方式,加入智能代理(AI Agent)可提高回答的準確度,完成複雜任務。智能代理是針對大模型一連串指令,要求大模型回答前後,執行一系列操作,甚至由多個智能代理協作。智能代理與傳統工作流程分別在於,透過反覆運算和對話模式,讓大模型反思答案和自我矯正、規劃工作過程,自動校訂錯誤,提供更準確結果。

瞄準目標解決問題

吳恩達團隊研究發現,只要擅用智能代理,GPT-3.5表現甚至超越GPT-4。智能代理可代表組織數據和輸入操作,協調數據來源、軟件和用戶之間交流對話,建立起代理工作流(Agentic workflow),可應用在多個行業上;包括程式設計、研究和處理多模態生成。

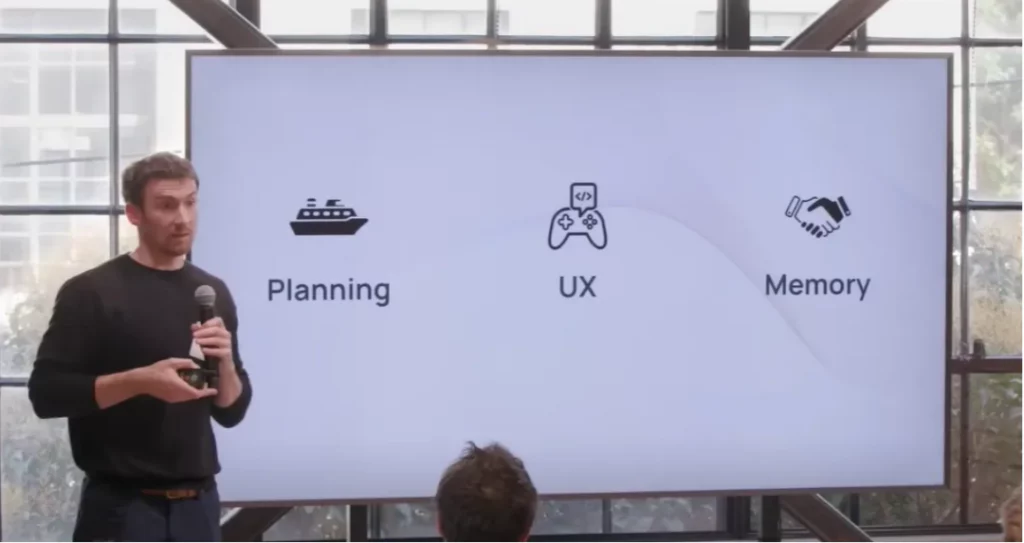

吳恩達提到了智能代理有四種設計模式,執行複雜任務,包括反思(Reflection)、使用工具(Tool Use)、規劃(Planning)和多智能代理協作(Multiagent Collaboration),例如請大模型先核實答案,取用外部工具協助,甚至為任務規劃步驟;或建立多個代理,例如由另一個作為「監工」,審查和測試答案,與人類辦事分工合作,按部就班,原來也不謀而合,建立「Agentic Reasoning」通過讓大模型自行推理,以目標導向解決問題。

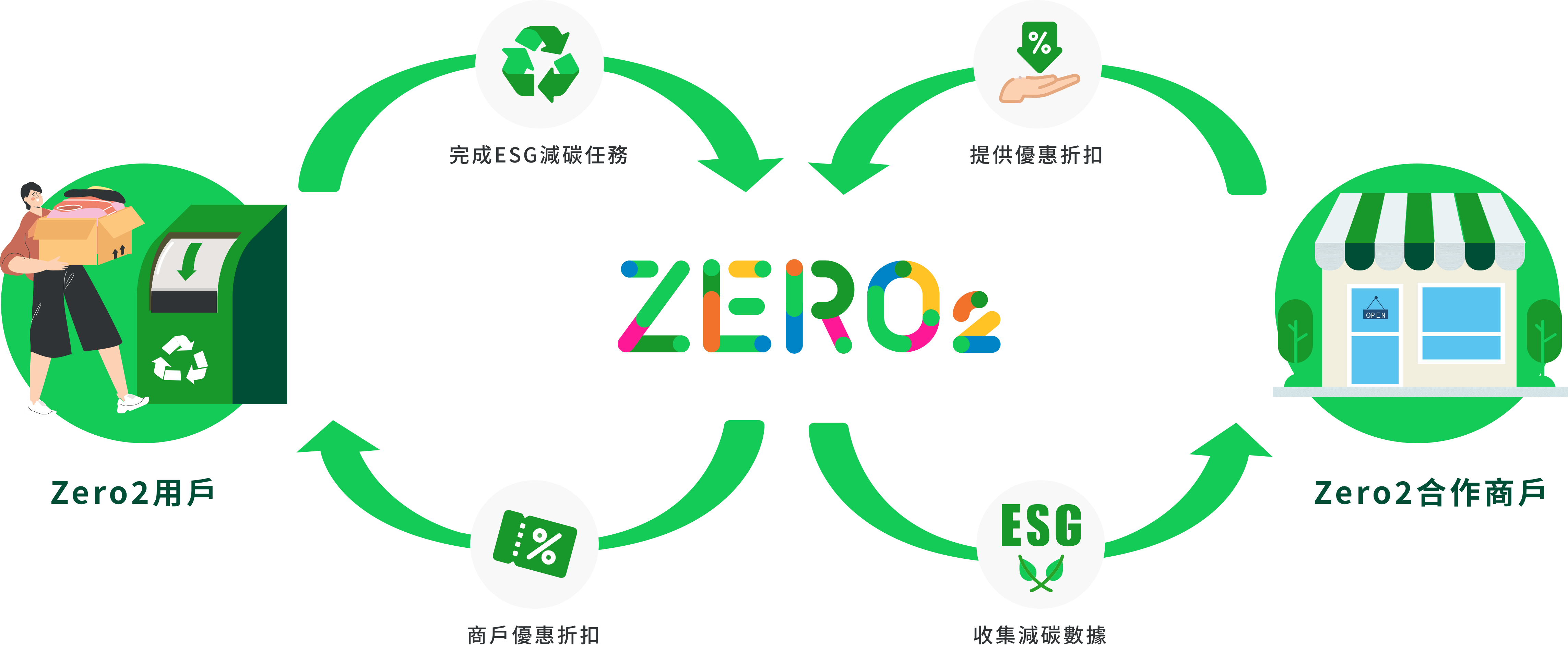

市場上有不少建立智能代理工具;包括Langchain和AutoGen。AI Ascent亦邀請 LangChain創辦人Harrison Chase介紹,智能代理可建立大模型與外部世界溝通,策畫步驟解決問題,改進用戶體驗、LangChain也提供不同用例的「鏈」(Chains),以特定方式組裝不同智能代理工作。

Google打破上下文限制

另一方面,大模型接受用戶的輸入,每次特定的對話之中,只能記住或參考一定數量的前面的輸入和輸出的參數,稱為上下文限制。上下文長度愈大,大模型可「記住」更長的文件內容和交談記錄,用戶也能建立更複雜的對話,解決更複雜的問題。

上月,Anthropic推出的Claude 3,上下文長度達200K tokens,相等於15萬字,可輸入一本短篇小說,按內容要求推理。Google Next 2024推出了公開預覽Gemini 1.5 Pro大模型,同樣採用MoE架構,上下文視窗達1百萬Tokens,為Claude 3四倍之多。

大模型的上下文長度愈來愈大,1百萬Tokens代表1小時影片、11 小時語音錄音、30,000行程式碼,超過700,000字,用戶輸入一套影片,大模型記住和分析每個場景。

Google研究人員在arXiv網站發表論文,提出Transformers with Infini-attention,突破上下文長度限制,讓大模型擁有無限記憶,可輸入不限長度內容。以往Transformer處理冗長上下文,受記憶體和運算資源限制,如今可處理無限長度輸入內容,也不增加額外記憶體和算力。

Google研究人員曾發表Attention Is All You Need論文,為大模型訓練立下開山之功,現時所有大模型,全基於Transformer的突破。無限記憶力大模型,最終究竟誰領風騷?也許Google不再失諸交臂。